相2.2终于来了,而且全面开源,相比于万相2.1具备更强大的能力、更卓越的性能和更出色的画面质量。

万相2.2终于来了,而且全面开源,相比于万相2.1具备更强大的能力、更卓越的性能和更出色的画面质量。万相2.2运用创新技术让让视频具有电影质感和影视级美学、能够更好的理解语义,能够直接生成更流畅的带运镜视频,还能对人物表情进行控制。

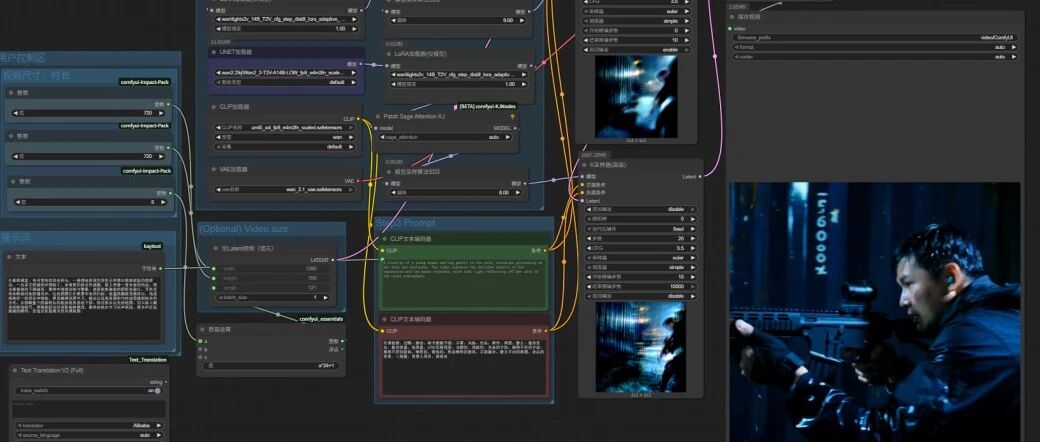

要想在ComfyUI中使用Wan2.2,首先要把comfyUI和wanvideo节点更新到最新版本来到comfyUI主目录,在地址栏输入 CMD,调出命令行窗口如果出现requirements.txt这一行,说明依赖有变动,需要把依赖也安装一下。来到python文件夹,在地址栏输入 cmd,调出命令行窗口输入命令:>python -m pip install -r然后回到comfyUI主目录,找到requirements.txt文件,将它拖到命令行窗口,就会将依赖项安装到comfyUI的主程序里了。来到目录custom_nodes\ComfyUI-WanVideoWrapper在地址栏输入 cmd 调出命令行窗口,输入 git pull 命令,进行节点更新。如果有提示依赖要求更新,用上面同样的方法进行安装。wan2.2的模型可以到万相的项目页面下载,模型分为三种,分别是14B的文生视频、14B的图生视频和5B的图/文生视频https://tongyi.aliyun.com/wanxiang/welcome

以14B的文生视频模型为例,4090显卡的显存占用都已经接近23G了。如果显存不够,可以用5B的TI2V混合模型,5B模型也是支持24帧的720P视频的,当然,它的模型能力肯定要比14B的弱一些。还是以14B的文生视频模型为例,模型下载可以去huggingface或modelScope两个站点下载,没有魔法的同学可以到后面的站点下载。插件和模型安装好后,从模板中就可以看到最新的 Wan2.2 工作流。分别是14B的文生视频工作流、14B的图生视频工作流、5B的混合工作流。官方工作流打开后,发现加载了两个模型,一个是高频降噪模型,一个是低频降噪模型。高频降噪是为了快速构图,低频降噪是为了优化细节。这两个模型的体积都特别大,如果我们直接用官方工作流跑的话,需要耗费的时间特别长。高频降噪和低频降噪模型模型后面分别对应了两个高级采样器。注意看两个采样器,采样总步骤是20步,高频降噪的采样器只采样前10步,10步以后就交给低频降噪的采样器了。另外,在 add_noise参数那里,高频降噪采样节点是开启的,低频降噪采样节点是关闭的。为了提高工作流速度,我们需要对官方工作流做一些改动,增加了加速lora、sage_attention节点,同时还增加了中文提示词以及视频尺寸节点。加速lora节点和sage_attention节点为了节约时间,下面是一个时长为2秒的视频。视频中人物动作流畅,运镜效果像手持摄像机跟拍,比较真实。我很多提示词都是用AI写的,例如你找到一段不错的提示词后,将这个提示词给通义/豆包/deepseek,告诉它这段提示词包含场景、人物动作、人物面部描写、特写、镜头、镜头变换、场景变化等。 让它仿照它的结构再写一个。提示写好后如果你觉得还不错,可以直接拿来用,如果不好,你再针对性的对它再进行一些修改就可以了。https://www.runninghub.cn/post/1950219353737314306

感谢您的阅读,麻烦点个赞+在看吧!

没有评论:

发表评论