想要本地部署ComfyUI,理论上来说,没有显卡,用CPU也可以运行ComfyUI。但运行归运行,纯用CPU跑AI速度非常非常非常的慢,所以如果你要用CPU跑comyUI,也就是图个能打开,没有任意实际意义。关于显卡要求,运行ComfyUI的配置比stableDiffusion要低一些,最低3G的显卡就可以运行了。如果想要流畅运行comfyUI,最少要8G以上的显卡。如果你还想运行 flux 模型,推荐至少12G以上的显卡。最重要的一点,就是一定要用 nvidia 的显卡。1、AMD显卡可以安装 comfyUI吗

下面的链接是comfyUI的官方页面

https://github.com/comfyanonymous/comfyui

在页面的最底部可以看到,AMD显卡想要运行 comfyUI,只能在 Linux 上安装进行。

苹果电脑是可以安装 comfyUI 的,但它的速度也是比较慢的,所以,想要玩 comfyUI,只推荐 nvidia 的显卡,虽然AMD显卡和苹果电脑也能玩,但并不推荐。目前comfyUI 的主流安装方式有两种:一种是到 comfyUI的官网下载官方整合包,一种是用秋叶的整合包。https://github.com/comfyanonymous/ComfyUI/releases/latest/download/ComfyUI_windows_portable_nvidia.7z

https://pan.quark.cn/s/64b808baa960

无论你是使用官方整合包,还是秋叶整合包,解压后一定要放在一个没有中文和特殊符号的纯中文路径下。解压后双击运行带"cpu"字样的文件就是通过cpu来运行,带"gpu"字样的就是通过gpu来运行。点击运行后,会弹出一个黑色的命令行窗口,comfyUI在工作的全程都不要关掉。这里要注意:安装部署的过程和后面的节点安装是需要打开科学上网的。启运结束后,不要关掉命令行,在浏览器中打开下面的地址,打开comfyUI的工作界面。

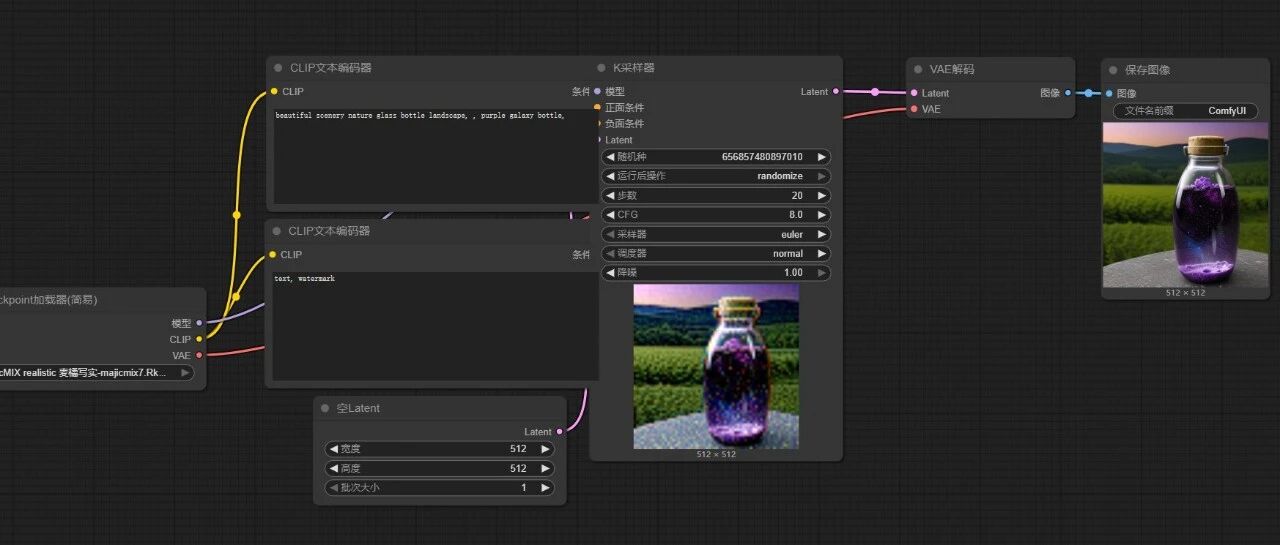

打开后的界面是一个 comfyUI基本的文生图工作流,因为我们没有下载模型,所以运行后报错。

http://127.0.0.1:8188/

秋叶整合包在易用性方面比官方整合包做得更好一些,它不仅把 comfyUI整合到了启动器里,还集成了环境和常用的节点等,省得我们再一个一个去下载安装了。comfyUI的更新速度非常快,通过秋叶整合包,我们可以很方便地切换到最新版本。在秋叶整合包里已经集成了很多常用的插件,我们可以很方便地通过整合包对插件进行下载和管理。刚打开的comfyUI界面是英文的,可以通过左下角的设置按钮,找到"AGL",将语言调为中文的。刚刚装好的comfyUI是不含模型的,如果你之前安装了SD,可以直接调用SD的模型。来到 "comfyUI"文件夹,找到"extra_model_paths.yaml.example",将后缀名删掉,改成"extra_model_paths.yaml",这个文件夹就正式生效了。用记事本打开"extra_model_paths.yaml"文件,将红框内的内容换成你的SD安装路径,这样comfyUI就能共享你SD中安装过的大模型、VAE、lora等模型了了。这里要单独说下controlnet模型的路径,文件中的设置要按下面的更改,才可以正常共享SD文件夹中的模型。设置好后,保存"extra_model_paths.yaml"文件,再重启 comfyUI就可以 了。

感谢您的阅读,麻烦点个赞+在看吧!

没有评论:

发表评论