Wan2.2_VACE终于来了,比Wan2.1_VACE在人物一致性、动作流畅度等方面提升了不少,今天我们来介绍它的用法。

Wan2.2_VACE是由阿里的pai团队开发的,官方模型也和Wan2.2一样分为高噪模型和低噪模型,但单个模型的大小达到了恐怖的34G,一般人的电脑肯定跑不起来这么大的模型。https://huggingface.co/alibaba-pai/Wan2.2-VACE-Fun-A14B好在kajai在抱抱脸上提供了wan2.2_fun的VACE模型,只有6个G左右。不过Kajai的模型要以模块化的方式配合官方模型进行使用。模型下载链接:

https://huggingface.co/Kijai/WanVideo_comfy/tree/main/Fun/VACE

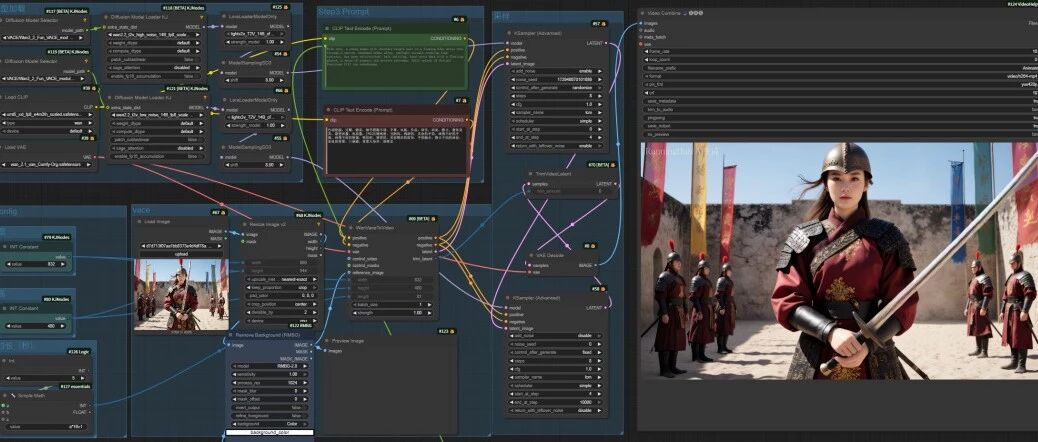

和wan2.2默认工作流一样,模型加载分为高噪模型和低噪模型两部分。先看中间的KJ的模型加载节点,这里加载的官方的高噪模型和低噪模型,KJ节点左侧连接的是刚刚我们下载的KJ模块,右侧连接的是加速lora,加载的是lightx2V模型。我们在图像加载节点后面加载了一个尺寸重置节点,用来重新定义图像的宽高比,然后图像传到VACEToVideo节点的参考图像那里,用来控制视频的画面。接着参考图片和提示词一起被传递给采样节点。这里和默认的Wan2.2工作流一样,分为高噪和低噪两个部分,最后输出成视频。如果我们想在生成的视频中重新生成一个场景,那么我们可以在图像尺寸重置节点后面加载一个去背景节点,将人物主体扣出来,生成一张白底人物图像就可以。用RMBG节点可以实现这个功能。去背景后,只要在提示词中加入相应的背景描述,我们就可以自定义视频背景了。

继续观看

Wan2.2_VACE来了,参考图片视频,首尾帧视频,动作控制视频全都有[ComfyUI教程]

,

Wan2.2_VACE来了,参考图片视频,首尾帧视频,动作控制视频全都有[ComfyUI教程]

关于RMBG节点的安装和用法,可以参考下面的文章:最后生成的视频和参考图片对比,人物的一致性非常强,动作也自然,比wan2.1又提升了很大一截。如果你不愿意写提示词,我在工作流的后面还添加了一个根据加载图片反推提示词的工作流。它可以结合我们输入的主题,自动生成Wan2.2视频提示词。如果你连主题也懒得写,它也可以只根据图片生成视频提示词。首尾帧工作流、动作控制工作流和图片参考工作流的基础部分是一样的,只是相应功能部分有所改动,这些工作流我都已经上传,而且都包含有反推提示词。https://www.runninghub.cn/post/1967609614747525122

https://www.runninghub.cn/post/1967612484775546881

Wan2.2-VACE首尾帧工作流:

https://www.runninghub.cn/post/1967612835457110018

----------我是分割线----------

【如何获取工作流】

目前RunningHUB可以说是插件和模型更新最快的网站了,如果想体验 ComfyUI最新版的功能,可以到RunningHUB上面去体验。如果通过我的邀请码注册,可以获得1000点积分,这些积分可以白嫖很长时间了,每日登录还能再获得100积分。https://www.runninghub.cn/?inviteCode=3qo65owt我的很多工作流也都上传到了RunningHUB平台上面,在平台上面搜索"青橙"就能搜到,这些工作流可以免费下载到本地,也可以用刚刚注册时送的积分免费在平台上面体验。

感谢您的阅读,麻烦点个赞+在看吧!

没有评论:

发表评论